Wesentlich aufwändiger als gedacht: Eine Auseinandersetzung mit der letzten groß angelegten Studie zur Wirksamkeit der Homöopathie, die sich mit Originalarbeiten beschäftigt: die im Jahr 2005 im Lancet veröffentlichte Arbeit von Shang et al.

In Kürze

Die Metaanalyse von Shang et al. aus dem Jahr 2005 kam zwar zu einem aus naturwissenschaftlicher Sicht zutreffenden, vernichtenden Urteil über die Wirksamkeit der Homöopathie, kann aber methodisch nicht überzeugen. Die Art der verwendeten Kennzahlen beeinflusst offenbar das Ergebnis erheblich. Darüber hinaus schließen die Autoren aus ihrer Meta-Regressionsanalyse auf das Vorhandensein eines Größeneinflusses der Studien, wobei aber andere denkbare Möglichkeiten der Erklärung nicht betrachtet werden. Das Ergebnis scheint daher nicht belastbar zu sein. Die Betrachtung nur der größten und qualitativ hochwertigen Studien führt auch nicht weiter, da die Auswahlkriterien der Studien für diese Untergruppe nicht nachvollziehbar dargestellt werden und daher möglicherweise nicht vorab festgelegt worden waren.

Trotz des wahrscheinlich zutreffenden Ergebnisses, dass die Homöopathie nicht besser wirkt als Placebo, kann diese Metaanalyse nicht überzeugen. Hätte man stattdessen die Durchführung der Einzelstudien bewertet, wäre man sicher schnell zu dem Schluss gekommen, dass deren Ergebnisse mit der 5%-Wahrscheinlichkeit für falsch-positive Resultate in Einklang stehen. Dies erscheint als ein wirkungsvollerer Ansatz, die Wirksamkeit der Homöopathie zu beurteilen, als die angewandten komplexen und angreifbaren Methoden.

Allgemein

Die Metaanalyse von Shang et al., die 2005 im Lancet veröffentlicht wurde, ist immer noch eine der wichtigsten Arbeiten zur Homöopathie, denn sie ist die bislang letzte, die sich mit originalen Forschungsarbeiten beschäftigt und dabei versucht, zu einer Bewertung der gesamten vorliegenden Evidenz zu kommen [1]. Die erst vor Kurzem veröffentlichte Untersuchung der australischen Gesundheitsbehörde greift auf vorhandene Metaanalysen zurück [2] – bezeichnenderweise nicht auf die Shang-Studie – und übernimmt damit zwangsläufig Sichtweisen, Interpretationen und gegebenenfalls auch Fehler der jeweiligen Rezensenten.

Die Schwierigkeit an der Shang-Studie hingegen liegt darin, dass von verschiedenen Seiten Kritik geübt wurde, die zu einem großen Teil nicht von der Hand zu weisen ist. Andererseits muss an der Kritik aber auch gelegentlich wieder Kritik geübt werden. Dies macht die Auseinandersetzung mit diesem Thema so komplex – und ist auch der Grund dafür, dass ich für diesen Artikel erheblich mehr und länger recherchieren musste als ich gedacht hatte.

Hintergrund

Die hier betrachtete Metaanalyse wurde im Auftrag des Schweizer Bundesamts für Gesundheit am Institut für Sozial- und Präventivmedizin der Universität Bern erarbeitet. Sie war Bestandteil des ‚Programms Evaluation Komplementärmedizin (PEK)‘, das Entscheidungsgrundlagen dafür liefern sollte, ob unter anderem die Homöopathie in den Leistungskatalog der Schweizer Gesundheitsversorgung aufgenommen werden sollte. Dazu wurden Wirksamkeit, Kosten und Sicherheit im Vergleich zu konventionellen Therapien betrachtet. Die Shang-Studie – gelegentlich nach dem Leiter des beauftragten Instituts auch als Egger-Studie bezeichnet – hatte die Wirksamkeit zum Thema.

Hinweis:

Derzeit ist das Thema wieder aktuell, weil der Schweizer Bundesrat im Mai 2014 beschlossen hat, auf eine Untersuchung der Wirksamkeit von Therapien der Komplementärmedizin zu verzichten und die Kosten dennoch von den Krankenkassen übernehmen zu lassen. Hierzu gibt es einen Appell der Schweizer Skeptiker (Link), dem man sich anschließen kann. Sicher wird die Schweizer Regierung die Unterschriften aus Deutschland und Österreich nicht in ihren Überlegungen berücksichtigen – eine ideelle Unterstützung der Schweizer Kollegen wird aber wohl auch nicht schaden.

Inhaltsübersicht

Auftragsgemäß sollte neben anderen Therapieformen (Anthroposophische Medizin, Neuraltherapie, Phytotherapie, TCM) auch die Wirksamkeit der Homöopathie im Vergleich zur konventionellen Medizin anhand von placebokontrollierten Vergleichsstudien untersucht werden. Hierzu betrachtete man Studien zur Homöopathie und hinsichtlich Indikation und Vorgehensweise direkt vergleichbare Studien der konventionellen Medizin. Damit ergaben sich folgende Auswahlkriterien für die in die Studie aufzunehmenden Homöopathiestudien:

- bis einschließlich 2003 veröffentlicht

- placebokontrollierte Vergleichsstudie

- randomisierte Gruppenzuordnung

- auswertbare Daten vorhanden

- eine Vergleichsstudie der konventionelle Medizin liegt vor

Insgesamt wurden 165 potenziell relevante Studien ermittelt, wovon aber 55 aus verschiedenen Gründen ausgeschlossen wurden, etwa, weil sie nicht aufgefunden werden konnten (9), keine Vergleichsstudie vorlag (7), über die gleiche Untersuchung mehrfach berichtet wurde (8). Einige zeigten auch das falsche Studiendesign, enthielten nicht die zur Auswertung benötigten Daten oder es trafen auch noch andere Gründe zu (zus. 31).

Im Wesentlichen sind mit dem Datenbestand zwei Untersuchungen durchgeführt worden, auf die im Folgenden noch näher eingegangen wird. Zuerst wurde in einer sogenannten Meta-Regressionsanalyse untersucht, ob die Größe einer Studie, das heißt die Zahl der teilnehmenden Versuchspersonen, einen Einfluss auf das Studienergebnis hat. Man fand, dass dies bei der Homöopathie durchaus der Fall war, und zwar so stark, dass der positive Effekt im Mittel praktisch verschwunden wäre, wenn man die Einzelstudien alle mit der größten Teilnehmerzahl aus dem ganzen Spektrum durchgeführt hätte. Shang et al. schlossen daraus, dass es sich bei der Homöopathie nur um eine Placebowirkung bzw. sogenannte Kontexteffekte handeln könne. Kontexteffekte sind solche, die sich aus dem Umfeld und den Gegebenheiten der Behandlung ergeben und nicht von der speziell angewandten Maßnahme – der Anwendung eines bestimmten homöopathischen Medikaments – abhängen.

Da sich ein starker Größeneinfluss zeigte, hat man daraufhin noch eine Untergruppe der qualitativ hochwertigen Studien mit hoher Teilnehmerzahl ausgewählt und gemeinsam betrachtet. Man kam zu dem Schluss, dass diese zwar im Mittel durchaus einen kleinen positiven Effekt aufzeigen, der aber nicht statistisch signifikant ist. Das heißt, der positive Effekt ist als ein Zufallsergebnis anzusehen, und mit einiger Wahrscheinlichkeit hätte sich auch ein gegenteiliger Effekt ergeben können. Auch dies stützt die Einschätzung der Autoren, dass die Homöopathie keine über Placebo hinausgehende Wirksamkeit aufweist.

Als die Studie im Lancet erschien, sahen sich die Herausgeber dazu veranlasst, in einem Leitartikel das Ende der Homöopathie zu verkünden [3], was sicher die Aufmerksamkeit auf diese Arbeit verstärkt und die Kritik daran beflügelt haben dürfte.

Natürlich hat die Analyse erhebliche Kritik auf sich gezogen, bezeichnenderweise nicht nur von Befürwortern der Homöopathie sondern auch von den Auftraggebern der Studie selbst. Von allen Kritiken, die ich bisher gelesen habe – was bestimmt keine vollständige Sichtung darstellt – erscheint mir die Kritik der PEK [4], von Lüdtke und Rutten [5], von Rutten und Stolper [6] und schließlich von Hahn [7] als die fundiertesten, daher werde ich diese in der folgenden Studienkritik neben meiner eigenen Sichtweise darstellen. Dabei beschränke ich mich allerdings auf die Homöopathie selbst und gehe nicht weiter auf den Vergleich zur konventionellen Medizin ein. Schließlich ist das Urteil ‚Homöopathie ist nur Placebo‘ eine absolute Wertung und unabhängig davon, was sich bei der Betrachtung der konventionellen Medizin ergab.

Generelle Kritik

Das Hauptproblem, das man als Homöopathiekritiker mit dieser Studie hat, ist, dass es eigentlich keine gute Studie ist. Sie bietet den Homöopathianhängern viel zu viele Ansatzpunkte zur berechtigten Kritik, so dass die Zweifel an der Studienmethodik schnell das Studienergebnis ins Gegenteil verkehren [8], was auch nicht zutreffend ist. Also, liebe Homöopathen, wenn Sie aus meinen folgenden kritischen Ausführungen schließen wollen, die Homöopathie sei eine wirksame Therapie, dann sollten Sie zuvor die letzten Abschnitte dieses zugegebenermaßen recht umfangreichen Artikels lesen.

Zunächst muss man einfach feststellen, dass die Veröffentlichung selbst eine mittlere Katastrophe ist, und man wundert sich, wie eine der renommiertesten medizinischen Fachzeitschriften der Welt dazu kam, dieses Manuskript in der vorliegenden Form zu publizieren. Grundsätzlich sollen die Leser zumindest prinzipiell in die Lage versetzt werden, die angestellten Untersuchungen nachzuvollziehen – das ist eine Forderung, die das Lancet Jahre zuvor selbst aufgestellt hatte. Erst auf Nachfragen in Leserbriefen wurden Daten nachgereicht, mal hier, mal da, daher auch die unten angegebenen vielen Quellen, in denen die Daten verstreut sind. Ganz wesentliche Daten – mit welchen Werten die einzelnen Studien in die Meta-Regression eingegangen sind – sind bis heute nicht publiziert.

Das sind zwar nur Formalien – aber dennoch enorm ärgerlich.

Meta-Regressionsanalyse

Mit einer Regressionsanalyse wird versucht, Daten zu strukturieren, indem man überprüft, von welchen anderen unabhängigen Variablen sie abhängig sind. Bei der Meta-Regressionsanalyse werden die Ergebnisse der in die Metaanalyse aufgenommenen Studien untersucht (Link). Shang et al. haben verschiedene Variablen erprobt, als Wesentliche ist die Größe der Studie dabei herausgekommen, weswegen sich die folgende Darstellung auf diese Analyse beschränkt.

Grundlage für diese Betrachtung ist ein sogenannter Funnel-plot (‚Trichter- oder Schornstein-Bild‘, Link). Hier wird die Größe der Studie über die Stärke der in den Studien ermittelten Effekten dargestellt. Da Studien mit geringerer Teilnehmerzahl stärker streuen als große, ergibt sich normalerweise ein Bild, das einem umgekehrten Trichter oder Schornstein ähnlich sieht, daher der Name. Aus Gründen des Urheberrechts kann ich den in der Shang-Studie für die Homöopathie-Studien angegebenen Funnel-plot hier nicht wiedergeben. Da die Studie aber frei im Internet verfügbar ist, kann der interessierte Leser über diesen Link die Studie öffnen und zu Fig. 2, obere Hälfte, scrollen (auf Seite 729).

Jeder einzelne dargestellte Punkt entspricht dem Ergebnis einer Studie – allerdings haben Shang et al. darauf verzichtet, Daten zu liefern, aus denen man nachvollziehen könnte, welche Studie zu welchem Punkt gehört. Die allermeisten Punkte liegen links von der gestrichelten senkrechten Linie, das heißt, in der betreffenden Studie erwies sich das Homöopathikum als wirksamer als das Placebo, rechts von der Linie wäre das anders herum.

Man erkennt die durchgezogene nach rechts oben weisende Linie, die die Regressionsgerade darstellt. Sie stellt quasi als Mittelwert die Abhängigkeit des Studienergebnisses von deren Größe dar. Da sie am oberen Ende die gestrichelte senkrechte Linie fast schneidet, bedeutet dies, dass die Wirkung im Mittel verschwinden würde (Odds Ratio = 1), wenn man alle Studien mit der Größe durchführen würde, die der maximalen Studiengröße entspricht.

Kennzahlen

Nun habe ich etwas ein Problem mit den Kenngrößen, die hier für die Regressionsanalyse verwendet wurden. (Achtung: dieser Abschnitt befasst sich sehr intensiv mit Kennzahlen und deren Bedeutung. Wer dies überspringen möchte, kann bis zum Abschnitt ‚Weitere Kritikpunkte‘ scrollen.)

Zunächst wird nicht die Anzahl der Studienteilnehmer als Maßzahl für die Studiengröße herangezogen, sondern der Standardfehler. Der Standardfehler ist eigentlich ein Maß für die Streuung der Ergebnisse, das prinzipiell mit zunehmender Größe der Stichprobe, das heißt, mit der Anzahl der Studienteilnehmer, abnimmt. Aber eben nur prinzipiell, nämlich, wenn gleichartige Untersuchungen miteinander verglichen werden, die mithin ähnliche Ergebnisse liefern müssten. In den Standarfehler fließen nämlich zwei Bestimmungsgrößen ein, die Streuung der vorliegenden Daten (Standardabweichung) und die Zahl der Teilnehmer. Ein kleiner Standardfehler kann mithin entweder eine große Teilnehmerzahl bei großer Standardabweichung oder eine kleine Teilnehmerzahl bei kleiner Standardabweichung bedeuten.

Da sich die Streuungen der Genesungszeit beispielsweise bei Gehirnerschütterungen und bei der Bekämpfung von Warzen sicher erheblich unterscheiden, folgt daraus, dass zwei Studien bei gleichem Standardfehler dennoch mit höchst unterschiedlichen Teilnehmerzahlen durchgeführt worden sein können, also verschieden ‚groß‘ waren.

Dieser Sachverhalt hat durchaus Konsequenzen für das Ergebnis der Metaregression.

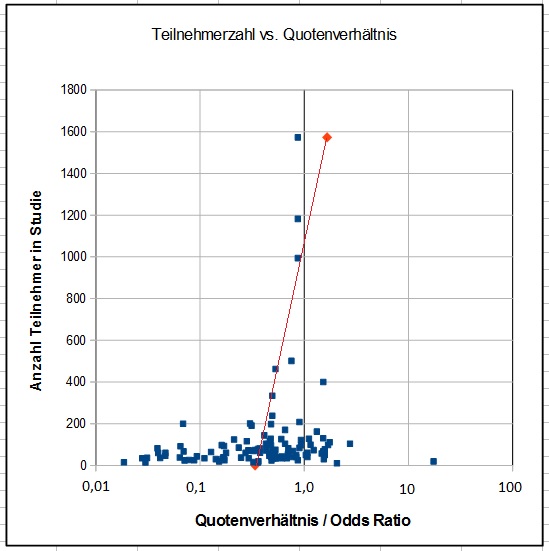

Verwendet man nicht den Standardfehler sondern tatsächlich die Zahl der Teilnehmer, ergibt sich ein Bild, das kaum Ähnlichkeit mit der Grafik bei Shang aufweist. Für das folgende Bild habe ich mir einmal die Mühe gemacht, die nur grafisch gegebenen Daten zur Effektgröße zu digitalisieren und der Anzahl der Teilnehmer gegenüberzustellen. Jetzt sehen wir den tatsächlich zu erwartenden Verlauf eines Funnel-plots, zwar etwas asymmetrisch, aber mit der Majorität der Studien im unteren Bereich. Folge: Bildet man jetzt die Regressionsgerade, bestimmt die Vielzahl der Studien unter ca. 50 bis 100 Teilnehmer den Startwert und die Studien mit hoher Teilnehmerzahl legen die Richtung fest. Bei Shang hingegen legt der große Punkthaufen zwischen SE = 0,6 und 0,0 einen Punkt fest, die Richtung wird durch die kleineren Studien (größeres SE, in der Grafik nach unten abgetragen) bestimmt.

Bild 1: angepasster Funnel-plot

Der Effekt ist immens.

Shang hatte die Regressionsgerade dafür benutzt, hochzurechnen, wie wohl ein Ergebnis aussehen würde, wenn es quasi dem Mittelwert aller Studien entspräche und mit der größten Teilnehmerzahl aller Studien ermittelt worden wäre. Dies wurde nach der Originalberechnung zu OR = 0,96 abgeschätzt, also als fast wirkungslos (s. unten). Nach meiner Regressionsrechnung (s. rötliche Linie) ergäbe sich für die größte Studie ein Wert von 1,66, also ganz sicher dem Placebo unterlegen (wobei ich allerdings keine Möglichkeit habe, meinen Rechenansatz per se mit dem von Shang zu vergleichen, es fehlen halt die Daten!).

Ist dieses Ergebnis – oder das von Shang – aber wirklich real?

Als Weiteres habe ich ein ebenso großes Problem mit der Verwendung der Odds Ratio (OR), dem Quotenverhältnis, als Kennwert für die Effektgröße. Die Effektgröße ist ein Maß für den Unterschied zwischen den beiden Vergleichsgruppen. Hier gibt es durchaus unterschiedliche Möglichkeiten der Darstellung.

Nehmen wir als Beispiel dieses fiktive Versuchsergebnis:

| Homöopathie | Placebo | Summe | |

| geheilt | 60 | 40 | 100 |

| nicht geheilt | 40 | 60 | 100 |

| Summe | 100 | 100 | 200 |

Zwanzig von hundert Patienten profitieren von der Behandlung, also jeder Fünfte. Die anderen werfen ihr Geld zum Fenster hinaus, sie wären entweder ohnehin geheilt worden oder auch mit dem Medikament nicht. Dies ergibt rechnerisch eine Effektstärke von 0,2 [9]. Im Allgemeinen betrachtet man eine Effektstärke von 0,1 als schwachen Effekt, 0,3 als mittleren und 0,5 und größer als starken Effekt (Link). Wir haben hier also einen eher schwachen Effekt vorliegen. Klingt nicht so schön.

Als nächste Stufe kann man das relative Risiko betrachten (Link). Demnach ist die Chance geheilt zu werden mit dem Homöopathikum 1,5 mal so hoch wie unter Placebo. Immerhin steht jetzt eine Zahl von 50 % im Raum gegenüber vorher nur 20 %. Wenn man bedenkt, dass Placebo eigentlich kein wirksames Medikament ist, klingt das auch noch nicht so toll.

Aber das Quotenverhältnis hilft (Link).

Die Quote ist definiert als das Verhältnis der Mitglieder einer Gruppe, die das Merkmal zeigen, zu denen, die es nicht zeigen, und nicht zur Gesamtmenge. Wenn von 100 Personen 75 geheilt sind, dann sind es 25 nicht, die Quote wäre also 3 (und nicht 0,75).

Die Quote unter Verum ist im obigen Beispiel also 60 / 40 = 1,5, unter Placebo 40 / 60 = 0,667. Das Quotenverhältnis ist also 1,5 / 0,667 = 2,25. Die Quote ist also mehr als doppelt so hoch. Mit etwas Glück findet man jetzt auch einen Journalisten, der das falsch versteht und zitiert, und schon ist ein mehr als doppelt so wirksames Medikament auf dem Markt. Die extrem großen Risiken für irgendwelche Risikogruppen, irgendetwas Schlimmes zu erleiden, kommen übrigens auf dem gleichen statistisch/journalistischen Weg zustande (Link), sonst wären sie nicht erklärbar.

Man muss mit Quotenverhältnissen auch eher logarithmisch denken, denn zwei genau gegenteilige Effekte ergeben als Quotient die Zahl 1. Das genaue Gegenteil eines Quotenverhältnisses von 10 ist 1/10, also 0,1. Erst als Logarithmus wird dies 1 bzw. -1.

Aber unabhängig davon ist das Quotenverhältnis als Kennzahl der Effektstärke für Vergleichszwecke eher ungeeignet, denn zumindest bei der Analyse dichotomer Daten wie im obigen Beispiel (geheilt / nicht geheilt) ist es nicht linear und vor allem nicht eindeutig.

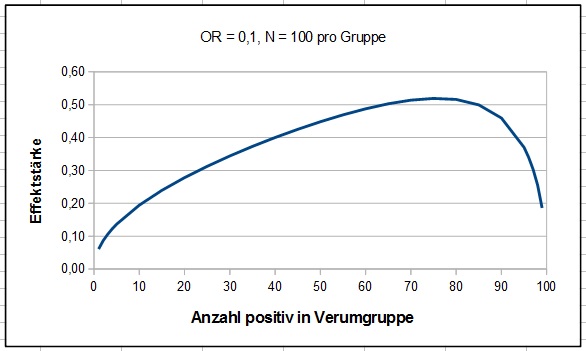

Ich habe einmal durchgespielt, wie sich Quotenverhältnis und Effektstärke verändern, wenn man einen fiktiven Versuch betrachtet, jeweils mit 100 Teilnehmern in Verum- und Placebogruppe. Dabei habe ich die Zahl der Erfolge der Verumgruppe variiert und die passenden Daten für ein Quotenverhältnis von 0,1 (entsprechend 10) ermittelt.

Bild 2: Mehrdeutigkeit des Quotenverhältnisses

Wie man erkennt, kann ein Quotenverhältnis von 0,1 sowohl einen starken Effekt kennzeichnen, im Maximum 0,52, als auch einen recht schwachen, im Rechenbeispiel im Extremfall 0,06 – und alle anderen Werte dazwischen. Mal profitieren mehr als die Hälfte der Patienten, ein anderes Mal weniger als ein Zehntel – oder eben irgendetwas dazwischen.

Damit erfüllt das Quotenverhältnis als Kennzahl in diesem Fall eine ganz wesentliche Forderung nicht, nämlich, dass gleiche Kennzahlen auch gleiche Zustände beschreiben müssen – sonst taugen sie nicht für einen Vergleich. Genau das ist aber hier der Fall. Quotenverhältnisse von 0,1 kommen hier durchaus vor, nur ob sie einen starken oder einen schwachen Effekt beschreiben, ist nicht erkennbar.

Die obige Grafik gilt für die Analyse kategorisierter Daten. Shang et al. haben hingegen für die Studien auch Quotenverhältnisse aus kontinuierlichen Ergebnisdaten ermittelt. Inwieweit hier die Vorbehalte der Nichtlinearität und der Mehrdeutigkeit auch zutreffen, kann ich derzeit nicht beurteilen. Da das Quotenverhältnis sinnvoll nur dann bestimmbar ist, wenn es auch Quoten gibt, scheint der Weg, aus kontinuierlichen Daten Quotenverhältnisse zu errechnen, eben über die Definition von Gut/Schlecht-Aussagen zu führen. Dann gelten die obigen Vorbehalte auch für diese Datentypen. Die von Shang et al. angegebene Quelle, wie die Umrechnung erfolgt, muss ich hier allerdings noch auswerten. Ob dies ergiebig sein wird, steht dahin, denn das Quotenverhältnis wird in der Zusammenfassung dieser Arbeit nicht erwähnt.

Schlussendlich ist es nicht möglich, aus den angegebenen Quotenverhältnissen die tatsächlichen Effektstärken zurückzurechnen. Damit kann man auch nicht nachvollziehen, ob die berichteten Daten die in den Einzelstudien vorliegenden Sachverhalte treffend wiedergeben. Man müsste hierzu alle 110 Studien sichten, wozu mir die Kapazität fehlt.

Dies waren jetzt die Vorbehalte zu dieser Analyse, die sich rein auf die angewandte Mathematik bzw. die verwendeten Kennzahlen beziehen.

Weitere Kritikpunkte

Aber ist es überhaupt gerechtfertigt, die 110 Studien gemeinsam zu betrachten – und ist das Bild halbwegs vollständig? Das sind die Vorbehalte, die praktisch alle anderen Autoren anführen.

Dass die Regressionsgerade im oberen Bereich zur Unwirksamkeit hin tendiert, liegt an der Asymmetrie der Daten. Am deutlichsten ist das im obigen Bild 1 zu erkennen. Wären die Punkte in etwa symmetrisch zur Odds Ratio = 0,5 angeordnet, dann würde die rötliche Regressionsgerade etwa senkrecht nach oben verlaufen, und bei der größten Studie ergäbe sich ein Quotenverhältnis von etwa 0,5, also eine unzweifelhafte Wirksamkeit der Homöopathika. Zur Symmetrie fehlen also eine Reihe kleiner Studien mit negativen Ergebnissen. Das führt zu der etwas absurden Schlussfolgerung, dass es mehrerer solcher negativer Ergebnisse bedürfte, um die Evidenz für die Homöopathie zu verbessern, oder dass es einige kleine positive Studien weniger geben müsste. Ich muss zwar zugeben, mich hier durchaus im Grenzbereich meiner Statistikkenntnisse zu bewegen, aber das kann ich einfach nicht glauben.

Aber, dessen ungeachtet, woher kommt die Asymmetrie?

Shang et al. gehen davon aus, dass in kleineren Studien die Effekte überbetont werden. Stellen Sie sich vor, in einem Sack wären nur schwarze und weiße Kugeln, und Sie sollen die Anteile herausfinden. Wenn Sie nur zehn Kugeln ziehen, ist der kleinste Wert, den man unterscheiden kann, 10 %. Um einen Unterschied von nur zwei oder drei Prozent zu ermitteln müssen wesentlich mehr Kugeln gezogen werden. Nach diesem Bild wäre die Größe des festgestellten Effekts eine Folge der Größe der Studie – und die Schlussfolgerung der Autoren wäre gerechtfertigt.

Eine andere Möglichkeit ist, dass, wie schon gesagt, bei kleineren Studien die Ergebnisse zwar eher streuen als bei großen, aber dass bei kleineren Studien die Wahrscheinlichkeit größer ist, dass negative Ergebnisse einfach nicht zur Veröffentlichung gelangen, als bei den teureren größeren. Dieser Effekt wird als ‚Publication bias‘ oder auch als ‚Schubladenproblem‘ bezeichnet. Wenn dies vorliegt, dann kann man eigentlich nicht auf einen Größeneinfluss schließen. Je größer das Schubladenproblem ist, desto weniger zutreffend ist die Schlussfolgerung der Autoren, da ja das Vorhandensein kleiner negativer Studien das Ergebnis für die Homöopathie verbessern würde.

Die Auftraggeber der Studie selbst führen einen weiteren Punkt an [4]. Eigentlich ist das Verfahren der Meta-Regressionsanalyse dafür gedacht, gleichartige Daten zu untersuchen und aus der Zusammenfassung zu einer größeren Datenmenge Effekte zu erkennen, die bei kleineren Einzelstudien nicht erkennbar sind. Hier wurde aber alles Mögliche in einen Topf geworfen, die verschiedensten Krankheitsbilder: Gehirnerschütterung, Muskelkater, Warzen, Durchfall und so weiter und so fort. Selbst wenn die Homöopathie eine wirksame Therapie wäre, dann wäre sicher nicht zu erwarten, dass diese in allen Fällen die gleiche Wirksamkeit zeigen würde. Wenn dies so ist, dann setzt sich der große Gesamt-Funnelplot aus vielen kleinen zusammen, was bei unterschiedlichen Wirksamkeiten keine Gesamtsymmetrie ergeben muss. Als Folge ist aus einer Neigung der Gesamtregressionsgraden nicht zu schließen, dass ein genereller asymmetrischer Größeneffekt vorliegt. Daher haben die Auftraggeber der Studie selbst deutlich bemängelt, dass ihnen Shangs Schlussfolgerung, Homöopathie sei nur Placebo, zu weit geht. Diese methodische Kritik wandelt sich natürlich bei den Befürwortern der Homöopathie dahingehend, dass die Auftraggeber die ganze Studie verworfen hätten, was wiederum die Wirksamkeit der Homöopathie beweisen könne [8].

Einen anderen Aspekt führen Rutten und Lüdtke an [5]. Bei der Auswahl der Studien für diese Untersuchung wurden auch sieben Studien nicht aufgenommen, da sich keine vergleichbaren Studien der konventionellen Medizin gefunden hätten, sowie weitere neun, die nicht aufgefunden wurden. Darunter seien aber vier Studien, die mit hoher Teilnehmerzahl für die Homöopathie positive Ergebnisse erbracht hätten und zudem auch in früheren Metaanalysen als qualitativ hochwertig eingeschätzt worden seien. Würde man diese in den Funnel-Plot mit aufnehmen, dann ergäbe sich ebenfalls eine steilere Regressionsgerade, was wiederum zu einem günstigeren Ergebnis der Hochrechnung geführt hätte.

Schließlich führt Hahn noch einen sehr interessanten Aspekt ein [7]: Man betrachtet üblicherweise, dass die vergleichsweise große Effektstärke bei kleineren Studien eine Folge der geringeren Genauigkeit und der höheren Streuung ist. Was aber, wenn es sich mit Ursache und Wirkung genau anders herum verhält? Letztendlich kosten große Studien einiges an Geld, mehr als kleine, und Forschungsgelder sind immer knapp. Wenn also bei einer Studie eine große Effektstärke zu erwarten ist, entweder weil entsprechende Erfahrungen bzw. Literaturangaben oder Vorversuche vorliegen, dann ist die geringe Teilnehmerzahl eher eine Folge eines großen Effekts und nicht die Ursache dafür. Aus wirtschaftlichen Gründen würde nur eine kleinere Zahl an Teilnehmern rekrutiert. Dann hat aber die Regressionsgerade keine Aussagekraft dahingehend, dass der Effekt bei hoher Teilnehmerzahl verschwinden würde, sondern eben nur für die bekannte Tatsache, dass man bei kleinen Effekten große Teilnehmerzahlen zur Entdeckung braucht.

So, damit soll es zur Regressionsanalyse genug sein. Ich kann ehrlich nicht beurteilen, ob die angeführten Vorbehalte alle zutreffen, und wenn ja, in welchem Ausmaß. Dazu liegen mir nicht genügend Informationen vor, und ich habe auch nicht die Kapazität, mich in vertretbarer Zeit in alle die angeführten und weggelassenen Studien einzufinden, um hier ein klareres Bild zu erlangen. Dass sich bei Verwendung anderer Kennzahlen wahrscheinlich deutlich andere Ergebnisse zeigen, der Umstand, dass es der Homöopathie an ein paar kleinen negativen Studien fehlt, um in Summe positiver dazustehen, lässt doch einige Zweifel hinsichtlich der Aussagekraft der Untersuchung aufkommen.

Obwohl das Ergebnis dieses Teils durchaus meiner Erwartungshaltung entspricht, muss festgehalten werden, dass die Methodik, die zu dem Ergebnis geführt hat, wahrscheinlich ungeeignet war.

Die Besten und Größten

Ausgehend von dem festgestellten Größeneffekt haben Shang et al. eine zusammenfassende Betrachtung der Studien angestellt, die als von hoher Qualität bewertet wurden und als ausreichend groß anzusehen sind.

Auswahlkriterien für die Qualität waren die allgemein üblichen Kriterien hinsichtlich der Angemessenheit von Randomisierung und Verblindung sowie das Beachten des Intent-to-treat-Prinzips, wonach über alle Studienteilnehmer berichtet werden muss. Dass diese Kriterien anzuwenden sind, darüber besteht durchgehende Einigkeit, dies wurde von keinem Kritiker beanstandet.

Beanstandet wurde aber sehr wohl, wie die Kriterien angewendet wurden. Rutten führt aus, dass es vier Studien gäbe, die in der früheren Metaanalyse von Linde aus dem Jahre 1997 als hochwertig eingestuft worden seien, drei davon mit hoher Teilnehmerzahl, von Shang et al. aber nicht in diese Gruppe aufgenommen worden sind.

Wenn dies auch nachvollziehbar erscheint, so erscheint der nächste Punkt eher etwas abwegig. Rutten bemängelt nämlich, dass Studien zur homöopathischen Behandlung von Muskelkater mit in die Betrachtung einbezogen wurden. Hier könne ja die Homöopathie nicht wirken, sie sei schließlich nicht als Therapie für Gesunde gedacht.

As treatment of healthy individuals is very rare in homeopathic practice this outcome has low external validity to judge the effect of homeopathy as a method.

Ein Muskelkater nach einem Marathonlauf, so muss man wohl vermuten, kann natürlich nur gesunde Menschen treffen, Kranke machen schließlich keinen Marathonlauf. Nun gut, es scheint mithin zwei Arten von Verstimmungen der Lebenskraft zu geben, was nach homöopathischer Auffassung die Ursache von Beschwerden und Krankheiten ist: echte Beschwerden eben und solche Erscheinungen, die sich nur wie Beschwerden anfühlen. Wie ist das mit Schwangerschaft, Verstauchungen, Gehirnerschütterungen und Operationsfolgen? Ähnliches gilt für die Studie, die sich mit der Vorbeugung gegen grippale Infekte befasst.

Der größte Vorbehalt besteht aber in der Frage, was denn eine ‚größere Studie‘ sei. Im Text von Shang et al. wird beschrieben, dass es sich um die Studien handele, die mit einem Standardfehler im unteren Quartilsbereich angesiedelt seien. Nur, welche sind das? Auch hier lassen uns die Autoren im Unklaren. Die kleinste der als ‚größere Studien‘ in die Betrachtung eingeflossenen Untersuchungen zeigt 98 Teilnehmer. Insgesamt haben 31 der 110 Homöopathiestudien 98 oder mehr Teilnehmer. Oder werden die Größendaten durch die Verwendung des Standardfehlers als Kriterium verzerrt? Das Quartil läge in der 28. Studie, was 104 Teilnehmern entspricht. Auch eine gerade Zahl (100 oder 90) würde nach einem vorab bestimmten Zahlenwert aussehen, aber 98?

Die ausgewerteten 8 großen Studien sind tatsächlich die nach Teilnehmerzahl gerechnet größten Studien mit guter Qualität. Also scheint die Verwendung des Standardfehlers als Kriterium die Reihung doch nicht allzu sehr durcheinandergebracht zu haben, jedenfalls nicht hier.

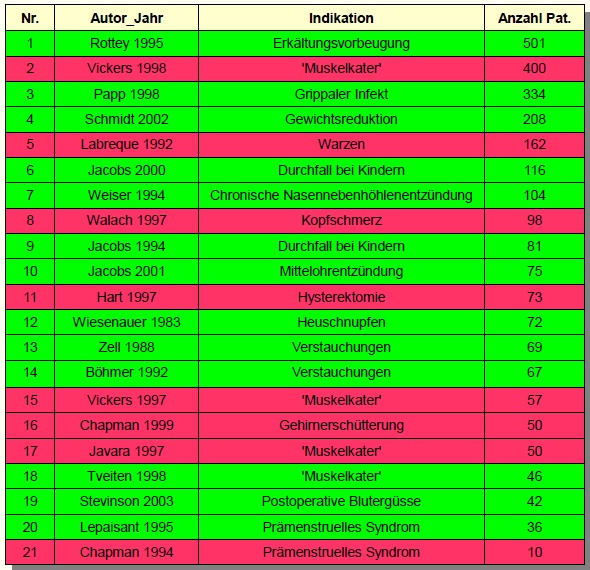

Die folgende Tabelle gibt die 21 von Shang et al. als qualitativ hochwertig angesehenen Studien wieder. Die grün unterlegten Zeilen kennzeichnen für die Homöopathie positive Studien, rot das Gegenteil. Die Studien mit den Nummern 1 bis 8 sind in die Endauswertung der ‚großen Studien‘ eingeflossen.

Tabelle 1: Qualitativ hochwertige Studien

Man erkennt, dass durchaus die größere Zahl der Studien zu einem positiven Ergebnis kam, wenn auch manchmal nur recht schwach. Damit ist klar, dass es von dem angewandten Grenzwert abhängt, bis zu dem die Studien berücksichtigt werden, wie das zusammengefasste Ergebnis aussieht. Das lässt auch den Verdacht aufkeimen, dass die Festlegung der Zahl 98 post hoc erfolgte, um die 8. Studie noch mit aufzunehmen, was das Ergebnis sicher nicht verbessert hat. Starker Tobak, aber nicht von der Hand zu weisen, denn die Autoren geben keine verständlichen Informationen zur Auswahl.

Also, auch dieses Ergebnis, dass die zusammengefasste Betrachtung der besten und größten Studien zwar eine Wirksamkeit der Homöopathie zeigt, dies aber mit einiger Wahrscheinlichkeit auch genau anders herum sein könnte, ist auf etwas fragwürdige Weise zustande gekommen.

… und jetzt?

Wenn man solche Reviews liest, auch die Kritiken dazu, dann fällt auf, dass sich eigentlich niemand mit dem Innenleben der Studien beschäftigt. Was immer die Studienautoren auch geschrieben haben, wird außer den Qualitätskriterien Randomisierung, Verblindung und Intent-to-treat nicht weiter überprüft. Dabei springen einen die Fehler manchmal geradezu an, selbst wenn man die Studie nur einfach liest. Hätten Shang et al. sich einfach diese kleine Mühe gemacht, man hätte sich das ganze zweifelhafte Auswahlverfahren sparen und auf die statistische Auswertung in weiten Teilen verzichten können.

Wie man solche Betrachtungen systematisch betreiben kann, hatte ich auf der Skepkon 2014 in München vorgestellt, eine entsprechende Fachveröffentlichung ist für die nächsten Monate geplant. Hier nur eine zusammenfassende Aufzählung der Vorbehalte zu den 13 für die Homöopathie positiven ‚qualitativ hochwertigen‘ Studien:

- Rottey 1995, Vorbeugung gegen Erkältungskrankheiten – negativ

Ergebnis nicht statistisch signifikant. Bewertung nach den in der Datenbank der Carstens-Stiftung zu findenden Angaben zum Ergebnis. - Papp 1998, Grippaler Infekt – negativ (Link)

Ungeeignete Auswertung: Zielkriterium durchschnittliche Krankheitsdauer wird nicht ermittelt, rund 30 % der Patienten werden dabei nicht berücksichtigt. - Schmidt 2002, Gewichtsreduktion – negativ

Mangelnde therapeutische Relevanz und winzige Effektgröße,die Unterschiede betrugen kurzzeitig nur wenige Gramm, zumeist auch noch in der falschen Richtung. - Jacobs 2000, Kindlicher Durchfall – negativ (Link)

Dominierender Effekt durch die gleichzeitige Trinktherapie am ersten Tag und deutliche Gruppenunterschiede können zu dem Ergebnis geführt haben, nach dem ersten Tag keine Wirksamkeit der Homöopathika erkennbar. - Weiser 1994, Chronische Nasennebenhöhlenentzündung – negativ

Inhomogene Punktvergabe zu einem Gesamtscore, gleiche Werte bedeuten nicht unbedingt gleiche Intensität der Beschwerden, Langzeitdaten nicht berichtet, subjektiver Vorteil bei Placebo. - Jacobs 1994, Kindlicher Durchfall – negativ (Link)

siehe oben (Jacobs 2000). - Jacobs 2001, Mittelohrentzündung – negativ

Nur Pilotstudie mit zu kleiner Teilnehmerzahl, Hauptergebnis nicht signifikant. - Wiesenauer 1983, Heuschnupfen – positiv

Nichts zu bemängeln. - Zell 1988, Verstauchungen – negativ

Es wurde Traumeel verabreicht, das zu einem hohen Umfang auch Wirkstoffe in Urtinkturkonzentration enthält. Wirkung der homöopathischen Anteile nicht nachweisbar. - Böhmer 1992, Verstauchungen – negativ

Wie Zell 1988. - Tveiten (1998), Muskelschmerz nach Anstrengung – negativ (Link)

Kein Testkriterium beschrieben, in sieben (!) größeren Studien nicht repliziert, kein objektiver Effekt gegeben. - Stevinson 2003, Schmerzen und Blutergüsse nach Operation – negativ

Keine Signifikanz, die Autoren selbst halten das erzielte Ergebnis für unbedeutend. - Lepaisant 1995, Prämenstruelles Syndrom – unklar

Studie liegt nicht vor. Dean berichtet, dass die Studie nicht randomisiert durchgeführt wurde, was allerdings zu den Selektionskriterien im Widerspruch steht.

Wie man sieht, bleibt eigentlich nur ein Studienergebnis bestehen, ein weiteres ist zweifelhaft wegen der unklaren Informationen zu dieser Studie. Ein bis zwei nicht negative Studien sind mit der Wahrscheinlichkeit von 5 % für ein falsch-positives Studienergebnis durchaus im Einklang.

Zusammengefasst:

Zur übergreifenden statistischen Auswertung der Studienlage bleiben einige Vorbehalte, die nicht zu entkräften sind. Daher bestehen erhebliche Zweifel an der Belastbarkeit der Einschätzung, bei der Homöopathie handle es sich um eine reine Placebowirkung. Dies sind aber Vorbehalte, die sich rein auf die angewandte Methodik beziehen, also auf die Art der Kennzahlbildung, der Studienauswahl und generell auf die Auswerteverfahren. Leider gibt dies den Verfechtern der Homöopathie aber die Gelegenheit, die Studie anzugreifen und sie eher als Hinweis auf eine vorliegende Wirksamkeit zu nutzen.

Eine Betrachtung der zugrundeliegenden Einzelstudien und eine Bewertung der internen Validität zeigt allerdings, dass die Ergebnisse selbst der allermeisten hochwertigen und großen Studien höchstwahrscheinlich nicht auf die Wirkung der homöopathischen ‚Arzneimittel‘ zurückgeführt werden können.

Die Metaanalyse hat zwar im Ergebnis Recht – das heißt, sie entspricht der skeptischen Erwartungshaltung – aber nicht unbedingt in der Methodik.

Literatur

[1] Shang A et al.: Are the clinical effects of homoeopathy placebo effects? Comparative study of placebo-controlled trials of homoeopathy and allopathy, Lancet 2005; 366: 726-32, Link zum Volltext: Hier

[1a] Liste der von Shang berücksichtigten Studien als Webappendix zur Originalveröffentlichung im Lancet: Link, erfordert Login, dann Beitrag öffnen und Webappendix 1 suchen!

[1b] Shang A et al.: Study characteristics of homeopathy studies, Homepage des Instituts für Sozial- und Präventivmedizin, Link

[1c] Shang A et al.: List of excluded homeopathy studies, Homepage des Instituts für Sozal- und Präventivmedizin, Link

[1d] Angaben zu den in das Endergebnis eingeflossenen Studien finden sich in: Shang A et al.: Are the clinical effects of homoeopathy placebo effects? Authors‘ reply: Lancet 2005; 366: 2083-84, Link, erfordert Login, dann Beitrag öffnen!

[2] Optum: Effectiveness of Homeopathy for Clinical Conditions: Evaluation of the Evidence, Overview Report, October 2013, Link

[3] The Lancet:’The End of Homeopathy‘, Lancet 2005; 366: 690, Link, erfordert Login.

[4] Melchart D et al: Programm Evaluation Komplementärmedizin (PEK), Schlussbericht 20.04 2005, Link zum Volltext

[5] Lüdtke R, Rutten ALB: The conclusions on the effectiveness of homeopathy highly depend on the set of analyzed trials, Journal of Clinical Epidemiology 2008; 61(12): 1197-1204, Link zum Volltext

[6] Rutten ALB, Stolper CF: The 2005 meta-analysis of homeopathy: the importance of post-publication data, Homeopathy 2008; 97: 169-177, Link zum Volltext

[7] Hahn RG: ‚Homeopathy: Meta-Analyses of Pooled Clinical Data‘, Forsch. Komplementärmedizin 2013; 20: 376-381, DOI 10.1159/000355916, Link zum Abstract

[8] Rutten L, et al.: Proof against homeopathy does in fact support homeopathy, Homeopathy. 2006;95:57–61. Kein Abstract verfügbar

[9] Schäfer T: Methodenlehre II, Verfahren für nominalskalierte Daten, Folie 10, Link zum Volltext

Ulrich Berger hat Recht, so erklärt sich die Auswahl der ‚großen Studien‘. Ich habe anhand der einzelnen Studiendaten einmal ndie Zahlenwerte nachgerechnet. Der untere Quartilswert für den Standardfehler aller 110 eingeflossenen Homöopathiestudien liegt bei SE = 0,42.

Alle 8 ‚großen Studien hoher Qualität‘ haben einen SE kleiner 0,42

Alle nicht eingeschlossenen Studien hoher Qualität haben einen SE größer 0,42.

Bei der Arbeit von Walach, der kleinsten der großen Studien, liegt SE bei 0,37.

Die Jacobs-Studie, die größte nicht eingeschlossene Studie, hat einen SE von 0,44.

Ein Viertel der bestehenden Studien zusammenzufassen und extra auszuwerten, ist ein plausibler Ansatz und kein abstruser Grenzwert, wie es ein Cut-off von n < 97 gewesen wäre.

Das könnte sein. Da bin ich erst einmal nicht drauf gekommen. Ich prüfe das bei Gelegenheit mal nach.

Soweit ich verstanden habe, sind die großen Studien jene mit einem SE im untersten Quartil der ursprünglichen 110 Studien; es gibt also 28 große Studien. Von diesen 28 finden sich 8 unter den 21 hochqualitativen Studien.

Danke für Ihr Kompliment.

Ich habe mir den Beitrag von 2014, bzgl. der Wirkungsnachweise mal angesehen und finde ihn richtig gut

Sehr sachlich und detailliert, reflektiert, auch auf Kritikpunkte eingehend

Viel besser kann man es in der kurzen Zeit nicht vermitteln

Und weiche Endpunkte, bei einer Studie über Durchfall-Erkrankungen…

Hat was

Der untere Quartilswert ist per Definition der Wert (des SE), den ein Viertel der Studien unterschreiten. Bei 21 Studien wäre das der Wert (des SE), der von fünf Studien unterschritten wird. Das von Shang beschriebene Vorgehen hätte also zu einer Auswahl von fünf Studien geführt, nicht von acht.

Vielleicht schon etwas spät, aber mir ist nicht klar, wo jetzt das Problem mit den „größeren Studien“ sein soll. Shang definiert diese als jene mit einem SE im untersten Quartil. Unter den 21 sind das eben jene 8. Die nach Probandenzahl kleinste davon hat 98 Teilnehmer. Was ist daran unklar oder dubios? (Außer natürlich für Lüdtke, Rutten, Stolper und Walach…)

PS: Dass man den SE statt der Probandenzahl wählen sollte, wird m.W. im einschlägigen Cochrane-Handbuch hervorgehoben und begründet.

Pingback: Homöopathische Aprilscherze oder meinen die das ernst? @ gwup | die skeptiker

Pingback: Ist Homöopathie wirkungslos? Natürlich, daran ändert auch Professor Robert Hahn nichts @ gwup | die skeptiker

Pingback: Gespräch mit einer Homöopathin | FSMoSophica

Pingback: @ gwup | die skeptiker

Wie gewohnt eine detaillierte und nüchterne Analyse. Vielen Dank dafür!!

Pingback: SkepKon-Rückblick: Die fehlende interne Validität von Homöopathie-Studien @ gwup | die skeptiker

Pingback: Methodisch angreifbar, aber das Ergebnis stimmt: Die Metaanalyse von Shang et al. @ gwup | die skeptiker

Der wesentliche Punkt ist, dass es für eine Wirksamkeitsstudie nur zwei mögliche Resultate gibt: (1) die eingangs formulierte Hypothese, eine bestimmte Therapie sei wirksam, ist nachgewiesen oder (2) sie ist es nicht. Ich habe das kurz als ‚positiv‘ und ’negativ‘ umschrieben. Daraus, dass die Wirksamkeit nicht nachgewiesen worden ist, folgt nicht, dass damit das Gegenteil bewiesen worden wäre. So ist auch der Begriff ’negativ‘ nicht gemeint. ‚Nachweis nicht gelungen‘ war mir zu lang.

Vielleicht etwas ausgeholt:

Wenn wir – ebenfalls als Hypothese – annehmen, dass die Homöopathie nicht wirken kann, dann müsste es sich bei den vorliegenden positiven Studienergebnissen um falsch-positive Ergebnisse handeln. Die Anzahl der qualitativ hochwertigen positiven Studien in der Endauswahl (13 von 21) scheint dieser Hypothese zu widersprechen, denn das ist mehr, als man mit der 5%-Wahrscheinlichkeit falsch-positiver Resultate – oder auch dem Publication bias – erklären könnte. Wenn man die Arbeiten aber genauer untersucht, dann kommt man zu dem Schluss, dass von diesen 13 nur eine (oder möglicherweise zwei) mit diesen Betrachtungen nicht zu widerlegen sind. Damit bleiben nur diese ein bis zwei Studien übrig, was sich nicht signifikant von dieser 5%-Wahrscheinlichkeit unterscheidet.

Das heißt, der Nachweis einer Wirksamkeit der Homöopathie ist anhand des zusammengefassten Ergebnisses dieser 21 Studien nicht möglich. Dass die Hypothese nicht verworfen werden kann, heißt wiederum nur genau das. Es heißt nicht, dass die Hypothese damit bewiesen wäre.

Das ist so ähnlich, wie wenn man in einem von der Außenwelt abgeschirmten Raum sitzt und jemand sagt, draußen regnet es. Man kann das nicht widerlegen – was aber nicht beweist, dass es wirklich regnet.

Ich verstehe nicht den Zusammenhang der Aussage: „Ein bis zwei nicht negative Studien sind mit der Wahrscheinlichkeit von 5 % für ein falsch-positives Studienergebnis durchaus im Einklang.“

Dieser Aussage geht eine Auflistung und Diskussion der herangezogenen Studien voraus. In dieser Auflistung werden alle Studien mit methodischen Fehlern als negativ gewertet. Ich würde jedoch annehmen, dass bei den meisten methodischen Fehlern die Studie jedoch als nicht vorhanden gewertet werden sollte.

Nun liegt mir keine der Studien vor. Daher greife ich als Beispiel mal auf eine fiktive Studie zurück. Diese vergleiche ein Phytopharmakum („Urtinkur“), das eine homöopathische Beigabe („potenzierte“ Wirkstoffe) enthält, mit Placebo und stelle eine signifikante Überlegenheit des Phytopharmakums fest. Dann macht das über die Wirksamkeit der homöpathischen Beigabe schlicht keine Aussage. Wenn die Autoren dieser Studie schreiben sollten, sie hätten die Wirksamkeit der Homöopathie belegt, ist das zwar Unsinn, berechtigt aber nicht, diese Studie in einer Metaanalyse als Evidenz gegen die Homöopathie zu verwenden. (Nach dem, was du über die Traumeel-Studien schreibst, könnten diese so aufgebaut gewesen sein wie dieses Beispiel. Da mir die Primärquelle nicht vorliegt, kann ich das aber nicht sagen.)

Absurde Schlussfolgerungen weisen meistens auf ein methodisches Problem hin. Die Punktwolke in Abbildung 1 (s. oben) zeigt deutlich, dass die Daten sich nicht gut durch eine lineare Regressionsgerade beschreiben lassen. Warum sollten sie das auch? In einer idealisierten Modellvorstellung müssten doch alle sehr guten (also sehr großen) Studien die gleiche – die „richtige“ – Effektstärke aufzeigen. Der Kurvenverlauf muss sich also für große N asymptotisch einer senkrechten annähern.

Im Prinzip müsste auch die Analyse von Shang et al. von diesem Problem betroffen sein. Ich meine aber, dass es dort weniger gravierend ist, da die Daten über dem Standardfehler (SE) aufgetragen sind, der nicht unendlich groß werden kann, sondern per Definition bei Null begrenzt ist.

So oder so bereitet die Methode aber auch deshalb Bauchschmerzen, weil der geringen anzahl guter (großer) Studien eine Vielzahl schlechter (kleiner) Studien gegenübersteht. Wie will man da vernünftig gewichten?

In meinem letzten Kommentar ist leider die Quelle des Zitates verloren gegangen, es ist der erste Absatz des Leitartikels von Harald Walach im Journal of Alternative an Complementary Medicine 9(1):7-13, 2003.

Vielen Dank für diese sehr ausführliche (und bestimmt äußerst zeitaufwendige) Arbeit.

Wie sich zu zeigen scheint, ist das Verfahren der Meta-Analyse gleichzeitig sehr wichtig, weil die Aussagekraft einzelner kleiner Studien doch begrenzt ist, und so etwas wie eine schwarze Kunst. Im Endeffekt müssen Studien zusammengeführt und zusammengerechnet werden, die sich in ihrer Methode unterscheiden, deren quantitative Ergebnisse also nicht ohne weiteres vergleichbar sind. Um zumindest eine gewisse Vergleichbarkeit herzustellen, kommt man daher wohl nicht um das Erstellen von Kennzahlen herum. Die Auswahl dieser Kennzahlen ist aber nicht eindeutig, das heißt, es gibt nicht den einen offensichtlich richtigen Weg, um einen komplexen Sachverhalt in eine einfache Kennzahl zu kondensieren.

Im Fall der Shang et al. – Studie von 2005 neige ich auch zu der Ansicht, dass einfacher und intuitiver besser gewesen wäre, also zum Beispiel eine Auftragung von Effektstärke über Teilnehmerzahl.

Nichtsdestotrotz kommt der Studie meiner Ansicht nach der Verdienst zu, Zusammenhänge zwischen Effektgröße und Studienqualität illustriert und analysiert zu haben. Ob man nun Shangs Funnel-Plot oder die hier gezeigte, modifizierte Version bevorzugt, so werden doch einige Trends klar:

– eine Vielzahl kleinerer Studien mit stark streuenden Effekten, in der Regel für die Homöopathie positiv, aber von der Effektstärke nicht so beeindruckend

– beim Übergang zu besseren (größeren) Studien eine Abnahme der Effektstärke mit gewisser Tendenz zu „praktisch null Effekt“, aber aufgrund der geringen Zahl hochwertiger Studien noch viel Unsicherheit

Die zahlreichen Diskussionen rund um die exakte statistische Methode, den gewählten Schwellwert für „größere Studien“ – und die Unterschiede zwischen statistischer und klinischer Signifikanz – stärken meines Erachtens die skeptische Position. Denn all diese Debatten um Feinheiten haben ja nichts mit dem Versprechen der Homöopathie zu tun:

Nach über zweihundert Jahren Homöopathie wäre es an der Zeit, wirklich gute experimtelle Belege vorgelegt zu bekommen. Reproduzierbare Versuche, anerkannte Methoden. Grundlagenexperimente ebenso wie Studien mit ordentlichen, relevanten Effektgrößen.

Wenn stattdessen letzten statistischen Feinheiten in Meta-Analysen klinischer Studien nachgejagt wird, legt das nahe, dass da eigentlich etwas ganz anderes analysiert wird, nämlich die je nach Kontext unterschiedlich starken unspezifischen Effekte – also Placebo, natürlicher Krankheitsverlauf, Regression zum Mittelwert usw.

Das schwierige, uneinheitliche Bild ist dann vielleicht schlicht eine Folge davon, dass man glaubt, Homöopathie zu erforschen, während man in Wirklichkeit eigentlich Daten rund um die geraden genannten unspezifischen Effekte sammelt. Was für sich genommen bereits ein faszinierendes Forschungsfeld ist.